sigmod和sigmoid的简单介绍

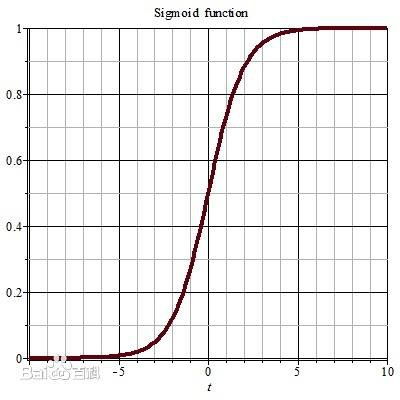

1、Sigmoid读法如下:Sigmoid函数是一个在生物学中常见的S型的函数,也称为S形生长曲线。

2、可乐的读音:英[kl],美[kol]。n.可乐;可乐果树。abbr.(COLA)生活费用调节。复数:colas。原形:colon。

3、由于激活函数的存在,在求偏导的时候,也要把它算进去,激活函数,一般用 sigmoid,也可以用 Relu 等。激活函数的求导其实也非常简单: 求导: f(x)=f(x)*[1-f(x)] 这个方面,有时间可以翻看一下高数,如果没时间,直接记住就行了。

1、尽管存在两个问题,但是Relu仍是目前最常用的激活函数。数学表达式:Leaky Relu激活函数就是针对Relu的Dead Relu Problem提出的。负半轴是 而不是0, 通常是一个很小的数。

2、常见激活函数及其导数:【注】Sigmoid 型函数是指一类 S 型曲线函数,为两端饱和函数。常用的 Sigmoid 型函数有Logistic函数和Tanh函数。

3、常见的激活函数:sigmoid,tanh,relu。sigmoid sigmoid是平滑(smoothened)的阶梯函数(step function),可导(differentiable)。sigmoid可以将任何值转换为0~1概率,用于二分类。细节可以 参考 。

1、tanh(x) 型函数是在Sigmoid型函数基础上为解决均值问题提出的激活函数:tang(x) = 2S(2x)-1。

2、有哪些激活函数可以选择呢?Relu,Rectified linear unit,x 大于 0 时,函数值为 x,导数恒为 1,这样在深层网络中使用 relu 激活函数就不会导致梯度消失和爆炸的问题,并且计算速度快。

3、其实很简单,比我们前面提到的所有激活函数都简单,表达式为:也就是说大于等于0则不变,小于0则激活后为0。

4、常见的激活函数:sigmoid,tanh,relu。sigmoid sigmoid是平滑(smoothened)的阶梯函数(step function),可导(differentiable)。sigmoid可以将任何值转换为0~1概率,用于二分类。细节可以 参考 。

5、BP网络要求激活函数处处可微,因此一般选S型函数(Sigmoid),常见的为对数S型函数(logsig)和正切S型函数(tansig)。

6、也叫 Logistic 函数,用于隐层神经元输出 取值范围为(0,1) 它可以将一个实数映射到(0,1)的区间,可以用来做二分类。 在特征相差比较复杂或是相差不是特别大时效果比较好。

1、该激活函数可以在移动端设备使用float16/int8低精度的时候也能良好工作。如果对 ReLU 的激活范围不加限制,激活值非常大,则低精度的float16/int8无法很好地精确描述如此大范围的数值,带来精度损失。缺点:与ReLU缺点类似。

2、当一个神经元以概率 keep_prob 为标准决定是否被激活,如果被激活,那么该神经元的输出将被放大到原来的 1/keep_prob 倍;如果不被激活,则神经元的输出为0。默认情况下,每个神经元是否被激活是相互独立的。

3、)如果使用sigmoid激活函数,则交叉熵损失函数一般肯定比均方差损失函数好;2)如果是DNN用于分类,则一般在输出层使用softmax激活函数和对数似然损失函数;3)ReLU激活函数对梯度消失问题有一定程度的解决,尤其是在CNN模型中。

4、总结一下人工神经网络需要非线性激活函数的原因:1,逼近复杂函数;2,将神经元的输出压缩进特定边界。

5、上面用到的激活函数为 sigmoid 函数,黄色曲线为 Sigmoid 的导数,它的值域在 0 到 1/4 之间:同时一般情况下神经网络在权重初始化时,会按照高斯分布,平均值为0标准差为1这样进行初始化,所以权重矩阵也是小于1的。

0

0

0

0

0

0

0

0

0

0

0

0

0

0

1

1

0

0

0

0